2. 同济大学 汽车学院,上海 201804

2. School of Automotive Studies, Tongji University, Shanghai 201804, China

变道是行车过程中十分常见的情况,例如, 需要换入左侧的快车道或右侧的慢车道;需要从左侧超车;需要在路口前换入特定方向车道.自动变道作为未来无人驾驶汽车的基本功能,包含环境感知、变道决策、轨迹规划和轨迹跟踪等多个重要环节[1].

环境感知可基于单一传感器,也可基于多传感器的融合.单一传感器探测方面,由于毫米波雷达、视觉传感器的出现和图像识别技术的发展提高了智能车辆对环境的自适应能力,促进了自适应巡航、车道保持、主动避撞、全景倒车辅助等系列智能化驾驶辅助技术的诞生,并实现了产业化,已经成为很多豪华车的标准配置.360°环视检测设备Li DAR的出现则直接推动了Google、福特等公司自动驾驶智能车的出现[2].

国内,针对环境感知的研究大多集中于清华大学、吉林大学等高校中.如侯德藻等[3]利用毫米波雷达、激光雷达开发了碰撞预警系统及自适应巡航(ACC)系统,利用CCD(charge coupled device)摄像机实现了车道保持,利用全景相机开发了环视倒车辅助系统等,并提供了具有实用性的控制技术,相关的技术在长安汽车、东风日产以及宇通、金龙等企业实现了推广应用.高振海等[4]基于车载毫米波雷达,采用自适应卡尔曼滤波算法实现了对前方目标的位置、速度的实时估计,并通过真实道路环境下的实车对比试验对算法的可行性和估计精度进行了试验验证.吴永存[5]设计了FMCW(frequency modulated continuous wave)毫米波雷达的单元平均恒虚警检测算法和选大恒虚警检测算法,降低了虚警概率并提高目标正确检测概率.其中,部分感知算法的性能达到了国际先进水平,但目前尚无与国外类似的系统集成技术.如毫米波雷达探测方面,国内尚无类似博世、德尔福等公司的高性能产品,但车用高性价比雷达研究已逐步展开.机器视觉感知方面,国内尚无类似Mobileye的成熟产品,但清华大学、武汉大学和海康威视、地平线机器人等提出的视觉算法性能已达国际先进水平,在2015年KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute)评测中取得多项单项第一[6].未来,若能结合已有视觉和雷达算法基础,加强信息融合,有望在复杂环境感知和集成应用方面取得重大进展.

近年来, 不少学者就多传感器信息融合算法、多传感信息进行驾驶员状态监测、车辆状态估计和交通环境感知展开了研究.Stiller等[7], Wojek等[8]和Premabida等[9]国外学者的大量研究工作表明, 多传感器数据融合在智能交通系统(ITS)和智能汽车(IV)领域可发挥重大作用.针对融合算法,Perrollaz等[10]提出一种概率方法以表征融合两个摄像头(立体视觉)的不确定性;奔驰研究人员Otto等[11]则在之前的单传感器多目标跟踪JPDA算法基础上,开发了JIPDAF算法,用来跟踪处于汽车前方及侧方盲区内的行人,并通过与3D激光扫描测量结果比较,验证了算法的有效性和准确性.国内学者孙宁等[12]在JPDA算法基础上,引入马氏距离进行观测值匹配,从而建立了系统观测模型和状态模型,并实现了目标级融合.智能汽车多传感器信息融合技术的应用也取得了诸多的相关成果, 如国内的G-BOS系统、欧洲的CVIS系统、美国的IVHS系统、日本的Smart Way系统等.

综上,环境感知系统的应用已经从倒车、车道偏离预警等基础功能发展到主动避障、自动变道等高级功能.开发性价比高的自动变道环境感知系统是其中关键.本文提出了一套面向中低速电动小车自动变道环境感知系统方案,在避障变道工况的验证下,取得了很好的效果.

1 自动变道环境感知系统环境感知的目的是对自动变道车辆周围的潜在障碍车的相对位置及速度进行识别,因此,分析潜在障碍车的位置和设计相应的探测方案是重点.

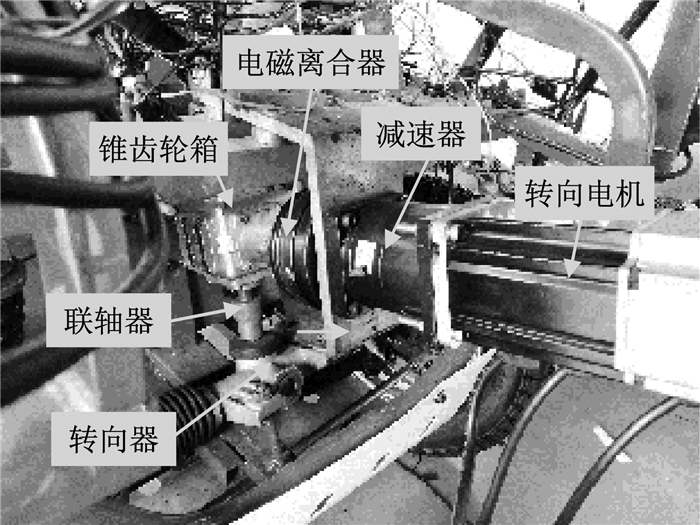

1.1 电动小车平台为实现自动变道功能,本文将电动小车传统转向系统改造为线控转向系统,方案如图 1所示.

|

图 1 转向系统结构改造方案 Fig.1 Structural transformation plan of steering system |

在实车转向系统改造中,使用一个锥齿轮箱实现了方向盘与转向电机的共同输入,并通过联轴器与转向器小齿轮固连,如图 2所示.

|

图 2 改造后的实车转向系统 Fig.2 Real vehicle steering system after transformation |

一次变道会涉及到两个车道,因此变道潜在障碍车辆会有多个.包括同车道前方车辆、目标车道前方车辆、目标车道后方车辆、目标车道并列位置车辆以及同车道后方车辆.

本文使用两个毫米波雷达、一个前视摄像头、两个超声波雷达实现前方和一侧车辆的感知功能,如图 3所示.若要在另一侧也实现同样的功能,可对称布置一套.由于试验小车车长比一般乘用车短,在一侧布置单个超声波雷达也基本满足需要.

|

图 3 传感器覆盖区域示意图 Fig.3 Area of sensor coverage |

前视摄像头负责同车道正前方目标的实时探测,毫米波雷达负责侧前和侧后区域的检测,兼顾前后方.超声波雷达探测距离较短,仅布置在侧面,用于探测是否存在相邻车道并排行驶的车辆.

在变道工况下,同车道后方车辆对于决策判断影响较小,而侧后方车辆会直接影响变道安全性,因此需要对其位置进行测量.但由于侧后方车辆驾驶员通常会对自车的变道行为进行主动调整,因此考虑到成本和精度需求,只使用后向毫米波雷达进行大角度观测.一般的变道情况下,侧前方车辆车速高于自车车速,因此对侧前方车辆的感知精度要求不高,只用一个前向毫米波雷达观测.正前方的车辆不会随自车的运动调整车速,并且一般变道都是由于前车车速不满足自车目标车速,因此正前方车辆是变道过程中最危险车辆之一.文中采用加权融合算法,对前视摄像头的检测数据与前向毫米波雷达的检测数据进行数据融合以利于观测,最终形成满足变道感知精度需求的低成本的环境感知系统.

2 前向毫米波雷达与前视摄像头融合算法本系统中使用一个前视摄像头模块和一个毫米波雷达进行数据融合试验.融合的对象为同车道前方车辆和自车的车距.这个数据对于正常跟车行驶和观察变道时都有着比较重要的意义,也处于前角的毫米波雷达与摄像头的共同检测覆盖范围内,因此可以选为数据融合的特征量.

两个传感器都可通过直接解析输出数据得到各自的距离测量结果.由于安装位置不同,它们对同一个空间参数的理论观测值就是不相等的,所以需要将其统一在同一个坐标系中.对于两种测量结果,试验中将使用加权融合算法,根据传感器测量精度的特性分配不同的权重,以期获得在各个测量距离上精度都较好的结果.

由于传感器在探测过程中可能误探测到非目标障碍物,融合过程中可以通过算法来消除这些干扰点的影响.当某个传感器通过自身标志位或目标位置判断目标非正常时,将会把权重降为0,即在非正常点上不参与融合,以避免偶然误差大幅度降低此点的融合后精度.通过这种方法,系统的稳定性将会比单个传感器要好,具体的数据融合思路见图 4.

|

图 4 数据融合逻辑流程图 Fig.4 Flowchart of data fusion logic |

在进行融合之前需要对传感器的数据做一些必要的处理,以保证不同传感器之间关联的正确性.可以从空间和时间两个方面来进行调整.

空间上的调整是指坐标系上的转换.由于安装位置上的差异,传感器的测量基准有所不同,一般都是以自身的位置作为基准的.毫米波雷达的基准是电磁波收发口,摄像头的基准在镜头处.因此将所有融合传感器的基准统一于某个点的位置.本系统试验中会用到一个激光测距仪作为比对,将以它的尾端作为基准.坐标关系俯视示意图见图 5.

|

图 5 系统坐标关系示意图(俯视) Fig.5 Relationship between system coordinate (top view) |

时间上,需要两种传感器采用相同的频率采样,一般可以通过线程同步来协调.本试验中将需数据融合的传感器以同一个Simulink模型驱动,合理设置好采样参数后,即可确保从不同传感器获得同步的数据.采样周期方面,毫米波雷达为50 ms,摄像头为20 ms,模型的采样频率不能超过两传感器的实际采样频率限制,否则会存在大量数据冗余.

2.2 加权融合算法加权融合算法的基本思路是多个传感器检测同一个待测量时,根据每个传感器的特性和可靠度,为它们各自的测量值添加相应的权重,加权求和后的数据可以结合不同传感器的优势,弥补在某些不利工况下稳定性偏低的问题.

假设系统中有N个传感器观察一个未知量Y,不同传感器的测量值用{Yj} (j = 0,1,2,…,N)表示.假设不同测量序列之间是无偏且相互独立的,则Y可由LMS(最小均方差估计)得到[13], 即

| $ Y = \sum\limits_{j = 1}^N {{W_j}{Y_j}} $ | (1) |

| $ \sum\limits_{j = 1}^N {{W_j}} = 1 $ | (2) |

方差估计可以表示为

| $ {\sigma ^2} = \sum\limits_{{\rm{ }}j = 1}^N {{W_j}^2{\sigma _j}^2} $ | (3) |

式中:σj(j=0, 1, …, N)为第j个传感器测量序列的方差.

在式(2)的约束条件下,对式(3)中的噪声方差求最小值,便可以求得最优的权值,表示为

| $ {W_j} = 1/\left( {{\sigma _j}^2\sum\limits_{i = 1}^N {\frac{1}{{{\sigma _i}^2}}} } \right) $ | (4) |

只要确定了σj(j=0, 1, …, N)的值,便可以求得数据融合过程中的最优权重系数.也就是说,传感器在融合中的权重取决于方差的关系,方差较小的测量更准确一些,所以占有更大的比重.在进行最后的加权计算前,需要得到参与融合的毫米波雷达和前视摄像头的方差估计值.如果使用固定值的方差σ1,σ2,则权重W1, W2也始终是确定的,但是由于毫米波雷达和摄像头在测量原理上的差异性,这与实际情况并不能完全相符.对于远处的目标,毫米波测距原理的优势较为明显,实际测量精度显著高于摄像头.而在近距离,由于毫米波在物体表面反射的位置并不是固定的,可能会因此影响其精度,所以摄像头近距离的性能略胜一筹.因此,应该以距离进行分段,求取各传感器在各个距离上的方差σ1,σ2, 然后代入式(4)计算得到各个距离上的最优权重W1,W2, 进而可获得权重随着距离的分布,融合后的数值将是方差最小的距离观测值.

3 实车试验验证 3.1 试验地点本次试验中,试验路段和车速的选择较为重要.同济大学嘉定校区内大多路段行人较多,而且每隔一定距离安装有减速带,试验用电动小车的减震系统较为简单,减速带的冲击会对试验效果带来较大影响,因此综合以上因素,考虑试验效果的准确性和过程的安全性,选择同济大学嘉定校区东门附近路段为试验路段,见图 6.

|

图 6 试验道路 Fig.6 Road for test |

将搭载了传感器的试验车和目标车停在同一条车道上,每隔一段距离进行一次数据采集.每次采集内容包括3项:实际距离(由激光测距仪测得)、前方毫米波雷达测量数据、前视摄像头测量数据.实际测定范围为3~30 m,对于大约30 m以上的静态目标,传感器的检测概率有明显的降低.因此选择此范围中的数据作为融合权重参考的数据.在20 m以内每隔1.5 m左右进行一次测算,20 m以上适当减少测量的密度.由于摄像头、毫米波雷达及激光测距仪安装时有纵向位置差,以及摄像头标定时有0.5 m预留车头长度,所以需要对直接测量值进行调整.调整后的测量值见表 1.

| 下载CSV 表 1 两种传感器权重分布的数据记录 Tab.1 Data recording of weight distributions of two sensors |

对得到的一系列“距离-权重”数据点进行曲线拟合,拟合函数为一维高斯函数.

| $ f\left( x \right) = a{{\rm{e}}^{ - {{\left( {x - b} \right)}^2}/2{c^2}}} $ | (5) |

式(5)中的参数拟合结果为:a=0.817 9,b=27.71, c=17.02.曲线如图 7所示,可以看到,曲线的总体趋势是上升的,这表明在远距离上,毫米波雷达的测距效果要优于摄像头,而在近距离,则是摄像头占有的比例更高一些,这与2.2中的分析结论基本相符.

|

图 7 毫米波雷达权重分布拟合曲线 Fig.7 Weight distribution fitting of millimeter wave radar |

完成了预备试验后,则开始数据融合试验.采集对象为同车道前方有接近趋势的车辆,涉及到的传感器有前方毫米波雷达与前置摄像头.

试验车从距离目标车约50 m的位置向前行驶,目标车在前方以低于试验车的较慢车速行驶,到指定位置启动数据采集模型,并开启激光测距仪的连续测量功能,直至试验车接近目标车的尾部,数据采集停止,试验过程结束.

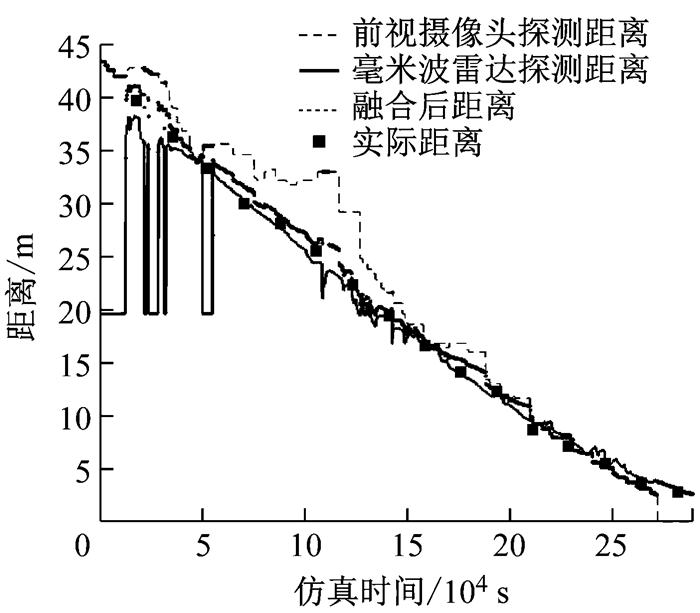

毫米波雷达和摄像头采集到的目标距离分别是图 8中的实线和虚线.纵坐标为距离,横坐标是时间(系统仿真时间,非实际时间).在后半段近距离测量中,两条线的相符程度比较高,而在20 m以外的远距离测量中,两种传感器采集的数据出现了较大幅度的差异,且毫米波数次出现了曲线走势突变的情况,这很明显是短时间的目标丢失.

|

图 8 融合试验中传感器采集到的目标距离 Fig.8 Target distance collected by sensor in fusion test |

下面再将经过融合后的目标距离曲线画在同一张坐标图上,即图 9中实心圆点.另外,将激光测距仪测得的数据以正方形点标在图 9上.

|

图 9 融合处理后的曲线与真实值的比较 Fig.9 Comparison of curve after fusion processing with the true value |

从图 9可以看出,融合曲线与真实值点的符合程度要显著高于单独的毫米波雷达或者摄像头的测量曲线.首先是在开始一段时间中毫米波雷达出现了目标丢失现象,通过融合算法已经基本消除了其影响.毫米波雷达的跟踪对象从目标车转移到附近的其他物体上,分析对象的方位角和距离位置可以推测,有可能是路边的树木等静止物体.由于方位角偏离了设定的自车道范围(约25°到50°),这段会大幅度影响融合结果的数据被过滤掉了,使融合结果的稳定性有了一定的提升.

在大概22 m到34 m这段行程内,摄像头的测量值出现了较大的偏差,但是因为中远距离的融合中精度较好的毫米波雷达权重更高,所以融合曲线依然在真值点附近.

不过即使是融合后也有部分偏差较大的时间段,例如25 m处的一小段中,由于毫米波受到干扰而产生了短时间的目标改变,同时摄像头的测量值准确度又偏低,这段就和真值产生了比较大的误差.本文设计的算法虽然可以一定程度上增加系统的稳定性和测量精度,但是不能从传感器层面提高其测量能力或稳定性,一旦出现了系统中传感器不够准确的时候,其结果可能会受影响,这也属于算法中仍然不够完善的地方.

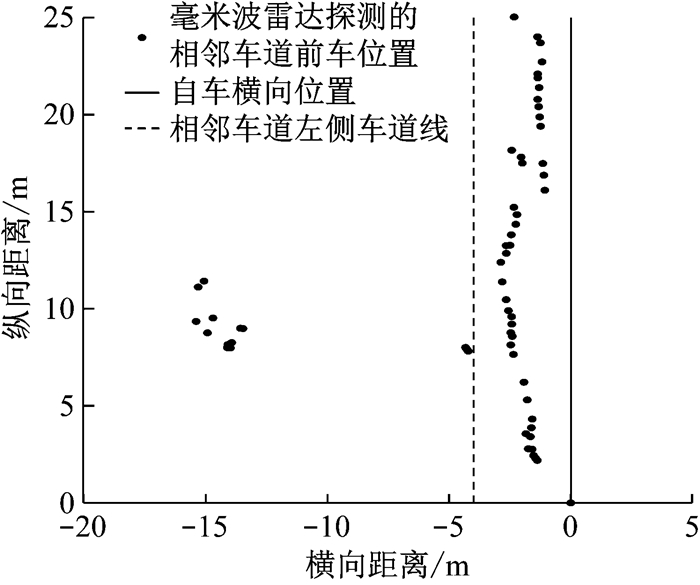

3.2.3 相邻车道行驶车辆检测试验对于相邻车道的变道障碍车辆,可分为3种情况.第1种是前车车速低于自车,第2种是后车车速高于自车,第3种是邻车道车辆与自车并行.

对于第1及第2种情况,分别用前向和后向毫米波雷达进行探测,图 10和图 11分别为两种情况下探测到的邻车道车辆轨迹,由毫米波雷达输出的目标距离及角度换算得到.可见,该布置形式的毫米波雷达可以较好地实现车辆的探测,有少许位置点因探测到路边障碍而偏离相邻车道,不过大部分情况下都可以很好地捕捉到相邻车辆.

|

图 10 毫米波雷达探测相邻车道前车试验 Fig.10 Detection tests of front vehicle in neighbor lane using millimeter wave radar |

|

图 11 毫米波雷达探测相邻车道后车试验 Fig.11 Detection tests of rear vehicle in neighbor lane using millimeter wave radar |

前述所有情景已经基本覆盖了车辆附近的道路环境,不过因为传感器的安装位置,侧面会有一块无法探知的盲区,虽然实际行车中此区域有其他车辆存在的时间很少,但是作为决策参考依然不能够忽略.超声波雷达的测量距离虽然偏短,但是可以作为系统的补充,布置在侧面以监测这块区域是否存在目标并返回距离值.在测量范围内不存在有效目标时,其返回示数保持为5 196.

4 结语本文针对智能汽车常见的自动变道工况,在一台中低速电动小车上构建了实现自动变道功能的平台.根据变道的感知需求,设计了低成本,满足精度需求的传感器布置方案.运用毫米波雷达、前视摄像头等传感器,获取变道潜在障碍车辆的位置和相对车速.对于危险程度较高的同车道前车的探测,运用加权融合算法以提高精度.最后,通过实车试验,验证了本文所设计的融合算法对感知精度的提升和传感器布置方案在实际变道场景中的适用性.

| [1] |

WANG Yangyang, FENG Rong, PAN Ding, et al. The trajectory planning of the lane change assist based on the model predictive control with multi-objective [C/CD]// Intelligent and Connected Vehicles Symposium. Shanghai: SAE, 2017.

|

| [2] |

谢志萍, 雷莉萍. 智能网联汽车环境感知技术的发展和研究现状[J]. 成都工业学院学报, 2016, 19(4): 87 XIE Zhiping, LEI Liping. The research and development of environmental perception technology in intelligent and connected vehicles[J]. Journal of Chengdu Technology University, 2016, 19(4): 87 |

| [3] |

侯德藻, 李克强, 郑四发, 等. 汽车主动避撞系统中的报警方法及其关键技术[J]. 汽车工程, 2002(5): 438 HOU Dezao, LI Keqiang, ZHENG Sifa, et al. The warning algorithm and some key technologies of vehicle collision avoidance system[J]. Automotive Engineering, 2002(5): 438 DOI:10.3321/j.issn:1000-680X.2002.05.018 |

| [4] |

高振海, 王竣, 佟静, 等. 车载毫米波雷达对前方目标的运动状态估计[J]. 吉林大学学报(工学版), 2014, 44(6): 1537 GAO Zhenhai, WANG Jun, TONG Jing, et al. Target motion state estimation for vehicle-borne millimeter-wave radar[J]. Journal of Jilin University (Engineering and Technology), 2014, 44(6): 1537 |

| [5] |

吴永存.汽车主动防撞毫米波雷达信号处理技术研究[D].绵阳: 西南科技大学, 2016. WU Yongcun. Research on signal processing technology of millimeter wave radar for automobile anti-collision[D]. Mianyang: Southwest University of Science and Technology, 2016. |

| [6] |

CHEN X, MA H, WANG X, et al. Improving object proposals with multi-thresholding straddling expansion[C]//IEEE CVPR. Boston: IEEE, 2015: 2587-2595.

|

| [7] |

STILLER C, FERNANDO P L, KRUSE M. Information fusion for automotive applications: an overview[J]. Information Fusion, 2011, 12(4): 244 DOI:10.1016/j.inffus.2011.03.005 |

| [8] |

WOJEK C, DOLLAR P, SCHIELE B, et al. Pedestrian detection: an evaluation of the state of the art[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2012, 34(4): 743 |

| [9] |

PREMABIDA C, NUNES U. Fusing LIDAR, camera and semantic information: a context-based approach for pedestrian detection[J]. The International Journal of Robotics Research, 2013, 32(3): 371 DOI:10.1177/0278364912470012 |

| [10] |

PERROLLAZ M, SPALANZANI A, AUBERT D.Probabilistic representation of the uncertainty of stereo-vision and application to obstacle detection[C]//Intelligent Vehicles Symposium (Ⅳ). San Diego: IEEE, 2010: 313-318.

|

| [11] |

OTTO C, GERBER W, LEON F P, et al. A joint integrated probabilistic data association filter for pedestrian tracking across blind regions using monocular camera and radar [C/CD]// Intelligent Vehicles Symposium (Ⅳ). Alcalá de Henares: IEEE, 2012.

|

| [12] |

孙宁, 秦洪懋, 张利, 等. 基于多传感器信息融合的车辆目标识别方法[J]. 汽车工程, 2017(11): 91 SUN Ning, QIN Hongmao, ZHANG Li, et al. Vehicle target recognition based on multi-sensor information fusion[J]. Automotive Engineering, 2017(11): 91 |

| [13] |

张彦楠, 杨彬. 加权数据融合方法在多声道超声波流量计测量中的应用[J]. 传感技术学报, 2017, 30(12): 1959 ZHANG Yannan, YANG Bin. Application of weighted data fusion method in multi-path ultrasonic flowmeter measurement[J]. Chinese Journal of Sensors and Actuators, 2017, 30(12): 1959 DOI:10.3969/j.issn.1004-1699.2017.12.029 |

2019, Vol. 47

2019, Vol. 47